Відеофейк: Військові «прийшли на розбірки» у Верховну Раду

Відеоролики не є справжніми, вони були згенеровані за допомогою штучного інтелекту. На роликах помітні типові ознаки AI-контенту: розмиті обличчя, помилки в екіпіруванні та символіці, неправильні кольори прапора України і відсутність природного руху губ. Технічна перевірка за допомогою DeepFake-O-Meter показала дуже високу ймовірність AI-генерації. Масове й однотипне поширення цих відео вказує на цілеспрямовану інформаційну атаку.

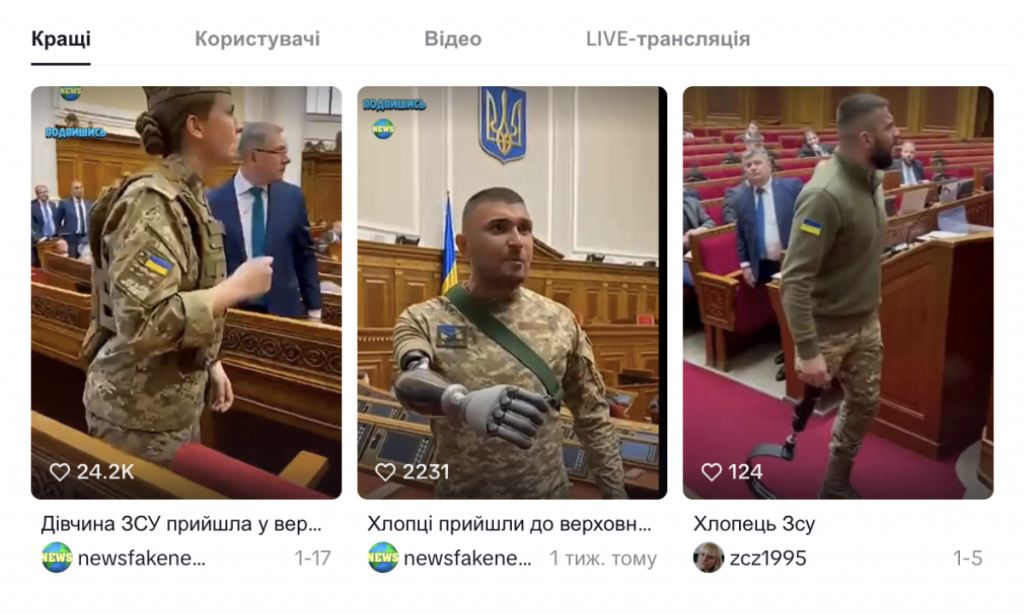

У соціальних мережах, насамперед у TikTok та Threads, активно поширюються відеоролики, на яких нібито українські військові та ветерани війни приходять на засідання Верховної Ради України й емоційно звинувачують народних депутатів у бездіяльності. У відео стверджується, що українським солдатам «нічим воювати», на позиціях «залишилося по три набої», немає турнікетів, дронів, тепловізорів і навіть палива. Ці заяви супроводжуються криками та агресивною риторикою, створюючи враження відкритого конфлікту між військовими та владою.

Насправді всі ці відеоролики сфабриковані й не мають стосунку до реальних подій. Вони були згенеровані з використанням технологій штучного інтелекту.

Це видно вже за уважного візуального аналізу. Обличчя людей на відео розмиті й неприродні, міміка та рухи – обмежені та статичні. Люди на задньому плані часто сидять нерухомо, без природних реакцій, що не характерно для реальних відеозаписів у публічних місцях. Елементи екіпірування військових містять численні помилки: на формі можна помітити неіснуючі чи спотворені нашивки, а державний прапор України нерідко має неправильні кольори чи пропорції – наприклад, поєднання жовтого, синього та знову жовтого кольорів або надмірно великий, нереалістичний розмір шеврона.

Нереалістичний вигляд має і сама зала засідань: в окремих роликах прапор України у приміщенні має неправильну кольорову схему, а архітектура та деталі інтер’єру не відповідають реальній залі Верховної Ради. Аналогічні візуальні помилки є і у відео з нібито ветеранами: протези зображені неправдоподібно, «зливаються» з одягом або мають форми, що не відповідають реальним медичним виробам.

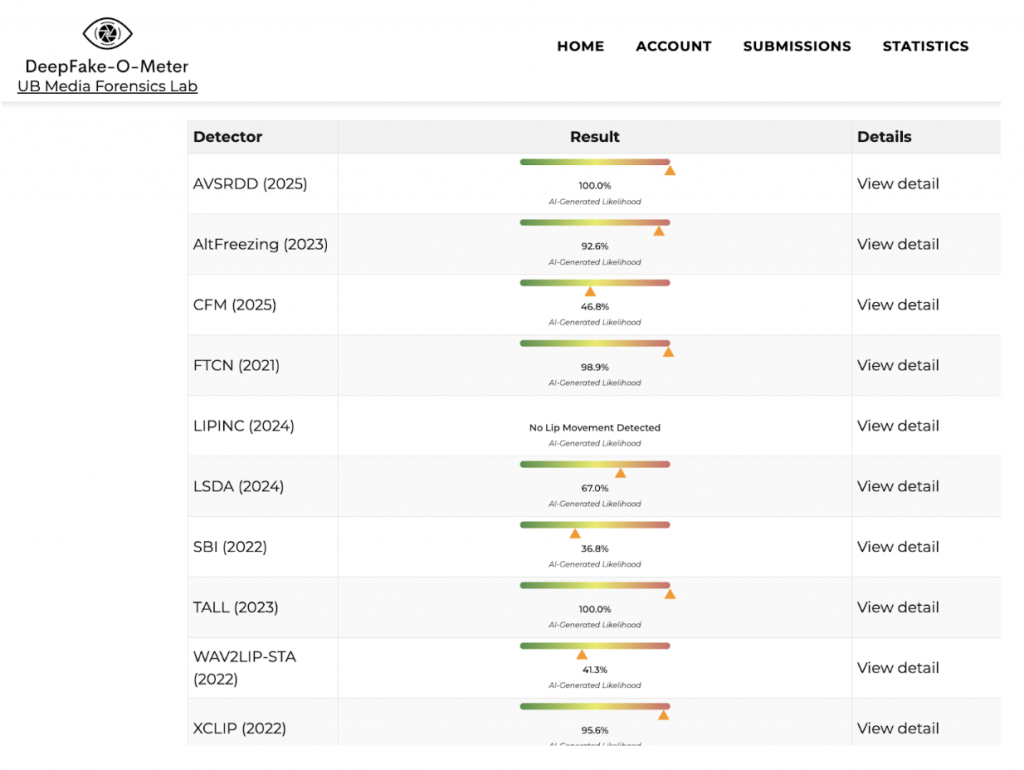

Для підтвердження висновків StopFake провів технічну перевірку цих відеороликів за допомогою інструменту DeepFake-O-Meter Лабораторії медіафорензики Університету Баффало (UB Media Forensics Lab). Цей інструмент аналізує відео з використанням набору незалежних алгоритмів, що виявляють ознаки AI-генерації та цифрових маніпуляцій. Для надійності кожен ролик було перевірено кількома детекторами.

Скриншот – zinc.cse.buffalo.edu

Скриншот – zinc.cse.buffalo.edu

Результати аналізу виявилися схожими та однозначними. Більшість детекторів показали дуже високу ймовірність штучного походження відео – від 90% до 100%. Такі значення характерні для синтетичного або суттєво модифікованого відеоконтенту і не відповідають параметрам автентичних відеозаписів.

Особливо показовим є результат детектора LIPINC, який зафіксував відсутність природного руху губ. Для реального відео з мовленням це нетипова аномалія і, як правило, свідчення використання технологій синтезу мови або накладання аудіодоріжки, коли голос не синхронізований з артикуляцією людини в кадрі. Окремі алгоритми показали середні значення, однак це не змінює загального висновку: різні моделі реагують на різні типи артефактів, а в подібних випадках вирішальним є сукупний аналіз, який вказує на використання штучного інтелекту під час створення чи маніпуляції відео.

Слід також звернути увагу до масовість і однотипність цих роликів. Вони поширюються одночасно на різних платформах і повторюють той самий сюжет – «військові приходять у Верховну Раду на розбірки». Це свідчить не про спонтанну реакцію, а про цілеспрямовану інформаційну кампанію.

Мета таких вкидань – порушити довіру між українським суспільством, збройними силами та владою, посіяти розбрат, посилити емоційну напругу та спровокувати агресію, у тому числі заклики до насильства щодо представників державних інститутів. Використання згенерованих «емоційних» відео дає змогу маніпуляторам посилювати ефект впливу, апелюючи до болю війни та реальних проблем, але замінюючи факти фальшивим контентом.

Раніше StopFake аналізував маніпулятивні повідомлення про те, що в січні українці нібито планували «вийти на Майдан» проти ТЦК.